Questões de Concurso Público PC-BA 2018 para Investigador de Polícia

Foram encontradas 100 questões

Algoritmos e desigualdade

Virginia Eubanks, professora de ciências políticas de Nova York, é autora de Automating Inequality (Automatizando a Desigualdade), um livro que explora a maneira como os computadores estão mudando a prestação de serviços sociais nos Estados Unidos. Seu foco é o setor de serviços públicos, e não o sistema de saúde privado, mas a mensagem é a mesma: com as instituições dependendo cada vez mais de algoritmos preditivos para tomar decisões, resultados peculiares – e frequentemente injustos – estão sendo produzidos.

Virginia Eubanks afirma que já acreditou na inovação digital. De fato, seu livro tem exemplos de onde ela está funcionando: em Los Angeles, moradores de rua que se beneficiaram dos algoritmos para obter acesso rápido a abrigos. Em alguns lugares, como Allegheny, houve casos em que “dados preditivos” detectaram crianças vulneráveis e as afastaram do perigo.

Mas, para cada exemplo positivo, há exemplos aflitivos de fracassos. Pessoas de uma mesma família de Allegheny foram perseguidas por engano porque um algoritmo as classificou como propensas a praticar abuso infantil. E em Indiana há histórias lastimáveis de famílias que tiveram assistência de saúde negada por causa de computadores com defeito.Alguns desses casos resultaram em mortes.

Alguns especialistas em tecnologia podem alegar que esses são casos extremos, mas um padrão similar é descrito pela matemática Cathy O’Neill em seu livro Weapons of Math Destruction. “Modelos matemáticos mal concebidos agora controlam os mínimos detalhes da economia, da propaganda às prisões”, escreve ela.

Existe alguma solução? Cathy O’Neill e Virginia Eubanks sugerem que uma opção seria exigir que os tecnólogos façam algo parecido com o julgamento de Hipócrates: “em primeiro lugar, fazer o bem”. Uma segunda ideia – mais custosa – seria forçar as instituições a usar algoritmos para contratar muitos assistentes sociais humanos para complementar as tomadas de decisões digitais. Uma terceira ideia seria assegurar que as pessoas que estão criando e rodando programas de computador sejam forçadas a pensar na cultura, em seu sentido mais amplo.

Isso pode parecer óbvio, mas até agora os nerds digitais das universidades pouco contato tiveram com os nerds das ciências sociais – e vice-versa. A computação há muito é percebida como uma zona livre de cultura e isso precisa mudar.

(Gillian Tett. www.valor.com.br. 23.02.2018. Adaptado)

Algoritmos e desigualdade

Virginia Eubanks, professora de ciências políticas de Nova York, é autora de Automating Inequality (Automatizando a Desigualdade), um livro que explora a maneira como os computadores estão mudando a prestação de serviços sociais nos Estados Unidos. Seu foco é o setor de serviços públicos, e não o sistema de saúde privado, mas a mensagem é a mesma: com as instituições dependendo cada vez mais de algoritmos preditivos para tomar decisões, resultados peculiares – e frequentemente injustos – estão sendo produzidos.

Virginia Eubanks afirma que já acreditou na inovação digital. De fato, seu livro tem exemplos de onde ela está funcionando: em Los Angeles, moradores de rua que se beneficiaram dos algoritmos para obter acesso rápido a abrigos. Em alguns lugares, como Allegheny, houve casos em que “dados preditivos” detectaram crianças vulneráveis e as afastaram do perigo.

Mas, para cada exemplo positivo, há exemplos aflitivos de fracassos. Pessoas de uma mesma família de Allegheny foram perseguidas por engano porque um algoritmo as classificou como propensas a praticar abuso infantil. E em Indiana há histórias lastimáveis de famílias que tiveram assistência de saúde negada por causa de computadores com defeito.Alguns desses casos resultaram em mortes.

Alguns especialistas em tecnologia podem alegar que esses são casos extremos, mas um padrão similar é descrito pela matemática Cathy O’Neill em seu livro Weapons of Math Destruction. “Modelos matemáticos mal concebidos agora controlam os mínimos detalhes da economia, da propaganda às prisões”, escreve ela.

Existe alguma solução? Cathy O’Neill e Virginia Eubanks sugerem que uma opção seria exigir que os tecnólogos façam algo parecido com o julgamento de Hipócrates: “em primeiro lugar, fazer o bem”. Uma segunda ideia – mais custosa – seria forçar as instituições a usar algoritmos para contratar muitos assistentes sociais humanos para complementar as tomadas de decisões digitais. Uma terceira ideia seria assegurar que as pessoas que estão criando e rodando programas de computador sejam forçadas a pensar na cultura, em seu sentido mais amplo.

Isso pode parecer óbvio, mas até agora os nerds digitais das universidades pouco contato tiveram com os nerds das ciências sociais – e vice-versa. A computação há muito é percebida como uma zona livre de cultura e isso precisa mudar.

(Gillian Tett. www.valor.com.br. 23.02.2018. Adaptado)

Algoritmos e desigualdade

Virginia Eubanks, professora de ciências políticas de Nova York, é autora de Automating Inequality (Automatizando a Desigualdade), um livro que explora a maneira como os computadores estão mudando a prestação de serviços sociais nos Estados Unidos. Seu foco é o setor de serviços públicos, e não o sistema de saúde privado, mas a mensagem é a mesma: com as instituições dependendo cada vez mais de algoritmos preditivos para tomar decisões, resultados peculiares – e frequentemente injustos – estão sendo produzidos.

Virginia Eubanks afirma que já acreditou na inovação digital. De fato, seu livro tem exemplos de onde ela está funcionando: em Los Angeles, moradores de rua que se beneficiaram dos algoritmos para obter acesso rápido a abrigos. Em alguns lugares, como Allegheny, houve casos em que “dados preditivos” detectaram crianças vulneráveis e as afastaram do perigo.

Mas, para cada exemplo positivo, há exemplos aflitivos de fracassos. Pessoas de uma mesma família de Allegheny foram perseguidas por engano porque um algoritmo as classificou como propensas a praticar abuso infantil. E em Indiana há histórias lastimáveis de famílias que tiveram assistência de saúde negada por causa de computadores com defeito.Alguns desses casos resultaram em mortes.

Alguns especialistas em tecnologia podem alegar que esses são casos extremos, mas um padrão similar é descrito pela matemática Cathy O’Neill em seu livro Weapons of Math Destruction. “Modelos matemáticos mal concebidos agora controlam os mínimos detalhes da economia, da propaganda às prisões”, escreve ela.

Existe alguma solução? Cathy O’Neill e Virginia Eubanks sugerem que uma opção seria exigir que os tecnólogos façam algo parecido com o julgamento de Hipócrates: “em primeiro lugar, fazer o bem”. Uma segunda ideia – mais custosa – seria forçar as instituições a usar algoritmos para contratar muitos assistentes sociais humanos para complementar as tomadas de decisões digitais. Uma terceira ideia seria assegurar que as pessoas que estão criando e rodando programas de computador sejam forçadas a pensar na cultura, em seu sentido mais amplo.

Isso pode parecer óbvio, mas até agora os nerds digitais das universidades pouco contato tiveram com os nerds das ciências sociais – e vice-versa. A computação há muito é percebida como uma zona livre de cultura e isso precisa mudar.

(Gillian Tett. www.valor.com.br. 23.02.2018. Adaptado)

Algoritmos e desigualdade

Virginia Eubanks, professora de ciências políticas de Nova York, é autora de Automating Inequality (Automatizando a Desigualdade), um livro que explora a maneira como os computadores estão mudando a prestação de serviços sociais nos Estados Unidos. Seu foco é o setor de serviços públicos, e não o sistema de saúde privado, mas a mensagem é a mesma: com as instituições dependendo cada vez mais de algoritmos preditivos para tomar decisões, resultados peculiares – e frequentemente injustos – estão sendo produzidos.

Virginia Eubanks afirma que já acreditou na inovação digital. De fato, seu livro tem exemplos de onde ela está funcionando: em Los Angeles, moradores de rua que se beneficiaram dos algoritmos para obter acesso rápido a abrigos. Em alguns lugares, como Allegheny, houve casos em que “dados preditivos” detectaram crianças vulneráveis e as afastaram do perigo.

Mas, para cada exemplo positivo, há exemplos aflitivos de fracassos. Pessoas de uma mesma família de Allegheny foram perseguidas por engano porque um algoritmo as classificou como propensas a praticar abuso infantil. E em Indiana há histórias lastimáveis de famílias que tiveram assistência de saúde negada por causa de computadores com defeito.Alguns desses casos resultaram em mortes.

Alguns especialistas em tecnologia podem alegar que esses são casos extremos, mas um padrão similar é descrito pela matemática Cathy O’Neill em seu livro Weapons of Math Destruction. “Modelos matemáticos mal concebidos agora controlam os mínimos detalhes da economia, da propaganda às prisões”, escreve ela.

Existe alguma solução? Cathy O’Neill e Virginia Eubanks sugerem que uma opção seria exigir que os tecnólogos façam algo parecido com o julgamento de Hipócrates: “em primeiro lugar, fazer o bem”. Uma segunda ideia – mais custosa – seria forçar as instituições a usar algoritmos para contratar muitos assistentes sociais humanos para complementar as tomadas de decisões digitais. Uma terceira ideia seria assegurar que as pessoas que estão criando e rodando programas de computador sejam forçadas a pensar na cultura, em seu sentido mais amplo.

Isso pode parecer óbvio, mas até agora os nerds digitais das universidades pouco contato tiveram com os nerds das ciências sociais – e vice-versa. A computação há muito é percebida como uma zona livre de cultura e isso precisa mudar.

(Gillian Tett. www.valor.com.br. 23.02.2018. Adaptado)

Algoritmos e desigualdade

Virginia Eubanks, professora de ciências políticas de Nova York, é autora de Automating Inequality (Automatizando a Desigualdade), um livro que explora a maneira como os computadores estão mudando a prestação de serviços sociais nos Estados Unidos. Seu foco é o setor de serviços públicos, e não o sistema de saúde privado, mas a mensagem é a mesma: com as instituições dependendo cada vez mais de algoritmos preditivos para tomar decisões, resultados peculiares – e frequentemente injustos – estão sendo produzidos.

Virginia Eubanks afirma que já acreditou na inovação digital. De fato, seu livro tem exemplos de onde ela está funcionando: em Los Angeles, moradores de rua que se beneficiaram dos algoritmos para obter acesso rápido a abrigos. Em alguns lugares, como Allegheny, houve casos em que “dados preditivos” detectaram crianças vulneráveis e as afastaram do perigo.

Mas, para cada exemplo positivo, há exemplos aflitivos de fracassos. Pessoas de uma mesma família de Allegheny foram perseguidas por engano porque um algoritmo as classificou como propensas a praticar abuso infantil. E em Indiana há histórias lastimáveis de famílias que tiveram assistência de saúde negada por causa de computadores com defeito.Alguns desses casos resultaram em mortes.

Alguns especialistas em tecnologia podem alegar que esses são casos extremos, mas um padrão similar é descrito pela matemática Cathy O’Neill em seu livro Weapons of Math Destruction. “Modelos matemáticos mal concebidos agora controlam os mínimos detalhes da economia, da propaganda às prisões”, escreve ela.

Existe alguma solução? Cathy O’Neill e Virginia Eubanks sugerem que uma opção seria exigir que os tecnólogos façam algo parecido com o julgamento de Hipócrates: “em primeiro lugar, fazer o bem”. Uma segunda ideia – mais custosa – seria forçar as instituições a usar algoritmos para contratar muitos assistentes sociais humanos para complementar as tomadas de decisões digitais. Uma terceira ideia seria assegurar que as pessoas que estão criando e rodando programas de computador sejam forçadas a pensar na cultura, em seu sentido mais amplo.

Isso pode parecer óbvio, mas até agora os nerds digitais das universidades pouco contato tiveram com os nerds das ciências sociais – e vice-versa. A computação há muito é percebida como uma zona livre de cultura e isso precisa mudar.

(Gillian Tett. www.valor.com.br. 23.02.2018. Adaptado)

“Uma segunda ideia – mais custosa – seria forçar as instituições a usar algoritmos para contratar muitos assistentes sociais humanos para complementar as tomadas de decisões digitais.”

Essa passagem do quinto parágrafo está corretamente reescrita, segundo a norma-padrão, em:

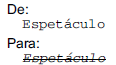

Deseja-se, em um documento editado no Microsoft Office Word (versão 2013 ou 2016, em sua configuração padrão e versão em português), mudar a aparência da palavra “Espetáculo”, da seguinte forma:

Considerando que a palavra “Espetáculo” esteja selecionada,

os botões de formatação de fonte que, se pressionados

em sequência, produzem essa transformação são:

Considere o seguinte cenário:

Um usuário de um computador com sistema operacional Windows 10 deseja fazer um backup de todos os arquivos de documentos pessoais, que totalizam cerca de 500 Mbytes, armazenados na pasta C:\Users\usuário\Documentos.

A forma mais adequada para realizar o backup é:

Considere a seguinte afirmação: Todo homem é bípede e mamífero.

A alternativa que apresenta uma negação lógica para essa afirmação é:

A emissora pública japonesa NHK emitiu um alarme falso sobre um problema nesta terça-feira (16.01), mas corrigiu o erro em alguns minutos. Não ficou claro de imediato o que causou a confusão, que acontece apenas quatro dias após outro alerta falso semelhante ter provocado pânico no Havaí. No sábado, os havaianos receberam uma mensagem nos seus celulares pedindo que se abrigassem; no entanto, tratava-se de uma falha desencadeada por um funcionário que, segundo as autoridades, havia apertado o botão errado.

(O Globo, 16.01.2018. Disponível em <https://goo.gl/ovC9rm> . Acesso em: 25.02.2018. Adaptado)

Esses falsos alertas estão relacionados

O presidente Michel Temer resolveu ir a Boa Vista nesta segunda (12.02) para discutir medidas emergenciais para a crise. Em quase dois anos, será a primeira viagem do presidente à capital de Roraima para cuidar do problema.

(Folha-Uol, 11.02.2018. Disponível em <https://goo.gl/oV5DRJ>. Acesso em: 25.02.2018. Adaptado)

O governo federal reconheceu a situação de “vulnerabilidade” no estado e