Questões de Concurso

Comentadas para analista (superior)

Foram encontradas 9.595 questões

Resolva questões gratuitamente!

Junte-se a mais de 4 milhões de concurseiros!

Uma estratégia eficiente utilizada pelo otimizador de consultas do SGBD considera o uso de:

A propriedade durabilidade tem relação com:

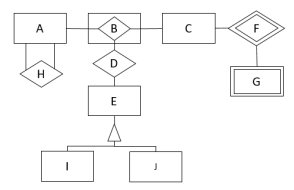

Observe o Modelo de Entidades e Relacionamentos a seguir.

Com base nos relacionamentos apresentados, está explícito que:

from nltk.corpus import stopwords from nltk.tokenize import word_tokenize

texto = "Eu sou um analista de dados da CVM!"

stop_words = set(stopwords.words('portuguese')) tokens = word_tokenize(texto)

tokens_processados = [w for w in tokens if not w in stop_words]

print(tokens_processados)

Considerando que o código foi executado sem erros e sabendo que Igor está usando Python 3.10.12 e NLTK 3.8.1, a saída do terminal foi:

Considere o código python a seguir.

import spacy

nlp = spacy.load("pt_core_news_lg")

doc = nlp("O rato roeu a roupa do rei de Roma")

print(doc[2].pos_, doc[2].dep_)

Os valores exibidos pela última linha são:

O problema que mais provavelmente motivou a recomendação do pesquisador e uma medida que pode mitigar esse problema são, respectivamente:

Considerando esse objetivo, dois algoritmos que podem ser utilizados para esse fim são:

Duas características do conjunto de dados que devem ser prioritariamente consideradas na escolha entre as duas técnicas são:

Os atributos de uma observação são: idade (inteiro >= 18), escolaridade (fundamental, médio, superior, pós-graduação), estado de residência (Acre, Alagoas, …, Tocantins, incluindo Distrito Federal) e local de trabalho (empresa, home office, misto).

O número mínimo de valores necessários para representar uma observação com os atributos acima descritos para o modelo de regressão, de forma que não ocorra perda de informação ordinal nem inserção de vieses nos dados, é:

Idealmente, o sistema permitiria aos auditores direcionar mais tempo às auditorias complexas e agilizar a análise dos casos mais simples, otimizando o custo de pessoal e equipamento especializado. Contudo, não examinar detalhadamente um caso complexo pode custar muito caro ao governo, a ponto de anular quaisquer ganhos obtidos usando o sistema com um pequeno número de erros.

Considerando esse cenário, e o fato de o sistema de classificação responder apenas “sim” ou “não” quanto à necessidade de exame detalhado, a métrica de classificação a ser maximizada pela equipe que irá implementar o sistema é:

Ao iniciar a operação do modelo com planilhas atuais, entretanto, os analistas observaram que o modelo teve um desempenho muito inferior, com precisão de apenas 72%. Investigando as planilhas recebidas, obtiveram a média e o desvio padrão para as duas colunas importantes com valores 5,34 e 3,68, respectivamente.

A explicação mais adequada à situação descrita é:

A equipe responsável pela implementação do projeto resolveu utilizar um modelo de linguagem recente para representar o máximo possível de informação contida num e-mail em um vetor de dimensão 768. Entretanto, depararam-se com o seguinte problema: as distâncias entre os vetores se mostraram muito pequenas, tornando o agrupamento por diversos algoritmos muito pouco significativo.

Com esse último problema em mente, a sequência mais apropriada de algoritmos a ser aplicada sobre os vetores, de forma a obter um agrupamento significativo dos e-mails, é:

Esses três atributos podem ser classificados, respectivamente, como:

Sabendo que o tamanho da amostra é 200 e que os valores maximizados das funções de verossimilhança dos modelos são 0,3; 0,4; 0,5; 0,3 e 0,5, respectivamente, Alexandre seleciona o modelo:

(se necessário, use ln(2) = 0,7; ln(3) = 1,1 e ln(5) = 1,6)

Nesse contexto, as soluções de Big Data para análise de dados devem ter a capacidade de:

Para isso, Miguel deve contratar o serviço de nuvem: