Na avaliação de um modelo para detecção de fraude, foi utili...

É correto afirmar que o modelo apresenta:

- Gabarito Comentado (1)

- Aulas (1)

- Comentários (4)

- Estatísticas

- Cadernos

- Criar anotações

- Notificar Erro

Gabarito comentado

Confira o gabarito comentado por um dos nossos professores

Clique para visualizar este gabarito

Visualize o gabarito desta questão clicando no botão abaixo

Comentários

Veja os comentários dos nossos alunos

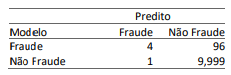

Precisão é o % de VP entre as predições positivas, ou seja, VP / (VP + FP). Sendo assim, será 4/5 = 0,8 ou 80%

Revocação ou recall é o % de VPs entre os positivos reais, ou seja, VP / ( VP + FN). Sendo assim seria 4/100 = 0,4 ou 4%. Desse modo, entendo que a questão está errada e deveria ser anulada.

De qualquer modo, ressalta-se que não se analisa o modelo apenas pela acurária. No caso em análise, o recall demonstra que o modelo não é adequado, seja com o valor de 4%, seja com o de 3%.

A acurácia mede quantas acertos do total da amostra (quantas Fraudes foram corretamente identificadas como Fraude e quantas Não-fraudes foram identificadas como Não-fraudes), dentro de todos os resultados.

A precisão, por sua vez, responde a questão: dentre todas as previsões de Fraude (4 + 1), quantas eram Fraude mesmo (4), o que na questão é igual a 80%.

A revocação/recall/sensibilidade, por sua vez, responde a questão: dentre todas as Fraudes (4 + 96), quantas Fraudes o modelo conseguiu verificar corretamente? Na questão, apenas 4 Fraudes foram detectadas em 100, logo, um recall de 4% apenas.

Como o Aaron disse, a questão deveria ser anulada pois o recall foi de 4% e não 3%.

Ainda assim, para melhor visualizar porquê do modelo não ser adequado, mesmo com uma alta acurácia, é importante ver o recall.

Ora, se em 100 fraudes só 4 foram detectadas, ainda que o modelo identifique corretamente as Não-Fraudes e possua uma boa precisão (das fraudes detectadas errou pouco), o modelo está deixando passar Fraudes, tornando-o insuficiente para a tarefa.

Os processos de descoberta de padrões descritivos e preditivos são diferentes, mas podemos calcular a performance dos algoritmos de Machine Learning com uma Matriz de Confusão. A matriz de confusão é uma tabela que permite extrair métricas que auxiliam na avaliação de modelos de machine learning para classificação — quando a variável resposta é categórica.

Para entender melhor este tema é preciso incialmente compreender os tipos de erros e acertos possíveis em classificadores.

- Verdadeiro Positivo (VP): falou que seria, e foi.

- Verdadeiro Negativo (VN): falou que não seria, e não foi.

- Falso Positivo (FP): falou que seria, mas não foi.

- Falso Negativo (FN): falou que não seria, mas foi.

Por tais valores podemos definir as Métricas de avaliação da Matriz de Confusão

- Acurácia (Acurary): Quantidade classificada como Positivos e Negativos corretamente, e pode ser formalizada em (TP + TN) / (TP + TN + FP + TN)

- Precisão (Precision): Quantidade Positiva classificada corretamente. E é calculada por TP / (TP + FP)

- Revocação (recall): Taxa de valores classificada como Positivo, comparada com quantos deveriam ser. E pode ser calculada como TP / (TP + FN)

- F1 SCORE: É calculado como a média harmônica entre Precisão e Recall, sendo sua formulação matemática representada por (2* TP) / (2* TP + FP + FN)

Com base nesses conceitos, vamos aos cálculos das métricas na matriz apresentada no enunciado.

A acurácia será

Acurária = TP+TN / TP+TN+FP+TN

Acurária=10003/10100

Acurária≈99%

Já a precisão será dada por

Precisão=TP /TP+FP

Precisão=4/5

Precisão=80%

.

Por fim, a revocação é igual a

Revocação=TP /TP+FN

Revocação=4/100

Revocação=4%

Pelas alternativas temos a letra (b) como a melhor opção, dado que apenas a acurácia não pode ser tomado isoladamente para uma tomada de decisão.

Gabarito Oficial: Letra D

Gabarito que deveria ser o correto: Letra B

essa questão não precisa de todos esses calculos, basta entender o enunciado

"Na avaliação de um modelo para detecção de fraude"

ou seja, a ideia principal do modelo é detectar corretamente as fraudes (VP)

é igual um modelo que visa que detectar uma pessoa com uma doença (não importa muito se ele detectou corretamente quem não tem a doença (FN), o que importa mais é se o modelo vai conseguir detectar a pessoa que está realmente doente (VP))

mas seguindo, vemos que das 100 fraudes ele só conseguiu detectar 4, o que já indica que ele não é adequado pra tarefa.

ja pode riscar A, B, C e E

não farei os outros calculos pois os colegas já fizeram

Clique para visualizar este comentário

Visualize os comentários desta questão clicando no botão abaixo