Na arquitetura de redes neurais, diferentes funções de ativ...

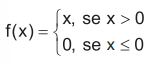

Ao implementar a função ReLU, um pesquisador deve seguir a fórmula:

Gabarito comentado

Confira o gabarito comentado por um dos nossos professores

Alternativa Correta: B

Vamos entender a questão e os conceitos por trás dela. O enunciado aborda a função de ativação ReLU (Rectified Linear Unit), amplamente utilizada em redes neurais devido à sua eficácia e simplicidade. A função de ativação é crucial em redes neurais porque introduz não-linearidade, permitindo que a rede aprenda e modele relações complexas nos dados.

A função ReLU é definida pela fórmula:

f(x) = max(0, x)

Essa função retorna o valor de x se ele for positivo e 0 se for negativo. Agora, vamos analisar as alternativas:

Alternativa A:

f(x) = 1 / (1 + e-x)

Essa é a fórmula da função sigmóide, não da ReLU. A função sigmóide é frequentemente utilizada em problemas de classificação binária, mas não é a função requisitada pela questão.

Alternativa B:

Esta imagem representa corretamente a função ReLU, onde f(x) é igual a max(0, x). Portanto, esta é a alternativa correta.

Alternativa C:

f(x) = tanh(x)

A função tangente hiperbólica, ou tanh, é outra função de ativação, mas não é equivalente à ReLU. Ela é simétrica em relação à origem, diferente da ReLU.

Alternativa D:

f(x) = max(0, x) - max(0, -x)

Essa expressão se equivale a x para qualquer valor de x, essencialmente uma função linear, e não uma função ReLU.

Alternativa E:

f(x) = √x2 + 1 - 1

Novamente, essa função não representa a ReLU. Ela é uma expressão diferente, sem relação com a ativação ReLU.

Resumindo, a função ReLU é uma escolha popular em redes neurais devido à sua simplicidade e eficácia. Entre as alternativas apresentadas, a Alternativa B é a correta porque representa a fórmula f(x) = max(0, x).

Clique para visualizar este gabarito

Visualize o gabarito desta questão clicando no botão abaixo

Comentários

Veja os comentários dos nossos alunos

Para o caso da ReLU, basta lembrar que seu valor varia entre 0 e infinito.

Sigmoid: varia entre 0 e 1

Tanh: -1 e 1.

a) Função Sigmóide (Logística)

b) Função Rectified Linear Unit (ReLU), nossa resposta.

c) Função Hyperbolic Tangent Activation Function (Tanh) incompleta. A forma completa é: f(x) = tanh(x) = (e^x - e^-x) / (e^x + e^-x)

d) e e) Parecem ser funções quaisquer que nunca vi serem usadas para ativação (me corrijam se eu estiver errado, por favor)

Fora estas, esperando serem cobradas em provas, ainda temos as Funções de Ativação: Maxout, Signum, Softmax, Softplus, Leaky ReLU, ELU, Linear, Não-Linear, Swish, Parametric ReLU, ArcTan... e as formas derivativas delas.

Gabarito: B

Clique para visualizar este comentário

Visualize os comentários desta questão clicando no botão abaixo